Syntaks:

Der findes en række tjenester, som Hugging Face tilbyder, men en af dets meget brugte tjenester er 'API'. API tillader interaktionen mellem de forudtrænede AI og store sprogmodeller til forskellige applikationer. Hugging Face leverer API'erne til forskellige modeller som angivet i følgende:

- Tekstgenereringsmodeller

- Oversættelsesmodeller

- Modeller til analyse af følelser

- Modeller til udvikling af virtuelle agenter (intelligente chatbots)

- Klassifikation og regressionsmodellerne

Lad os nu opdage metoden til at få vores personlige inference API fra Hugging Face. For at gøre det skal vi først starte med at registrere os på den officielle hjemmeside for Hugging Face. Tilmeld dig dette fællesskab af Hugging Face ved at tilmelde dig denne hjemmeside med dine legitimationsoplysninger.

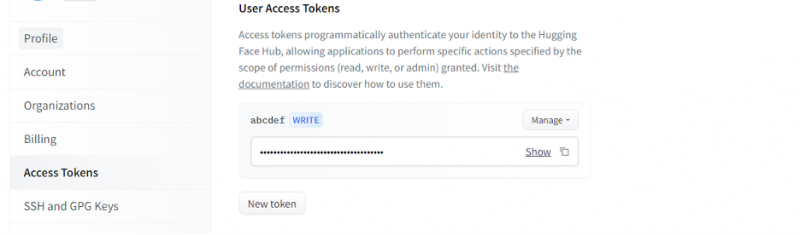

Når vi først har fået en konto på Hugging Face, skal vi nu anmode om inference API. For at anmode om API'en skal du gå til kontoindstillingerne og vælge 'Adgangstoken'. Et nyt vindue åbnes. Vælg indstillingen 'Nyt token', og generer derefter tokenet ved først at angive navnet på tokenet og dets rolle som 'SKRIV'. Et nyt token genereres. Nu skal vi gemme denne token. Indtil dette tidspunkt har vi vores token fra det kramme ansigt. I det næste eksempel vil vi se, hvordan vi kan bruge dette token til at få en inference API.

Eksempel 1: Sådan prototypers med Hugging Face Inference API

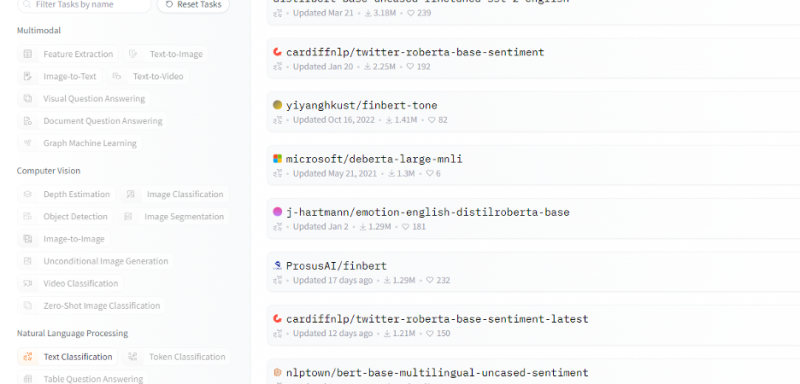

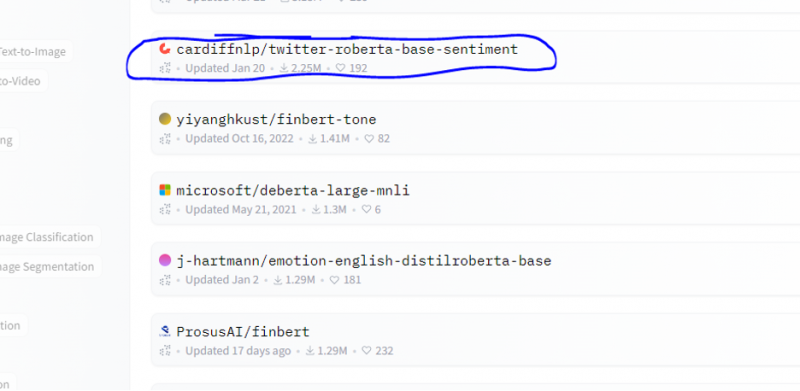

Indtil videre har vi diskuteret metoden til, hvordan man kommer i gang med Hugging Face, og vi initialiserede et token fra Hugging Face. Dette eksempel viser, hvordan vi kan bruge dette nygenererede token til at få en inferens-API for en specifik model (machine learning) og lave forudsigelser gennem den. Fra hjemmesiden til Hugging Face, vælg enhver model, du vil arbejde med, som er relevant for dit problem. Lad os sige, at vi vil arbejde med tekstklassificeringen eller sentimentanalysemodellen som vist i følgende uddrag af listen over disse modeller:

Vi vælger sentimentanalysemodellen fra denne model.

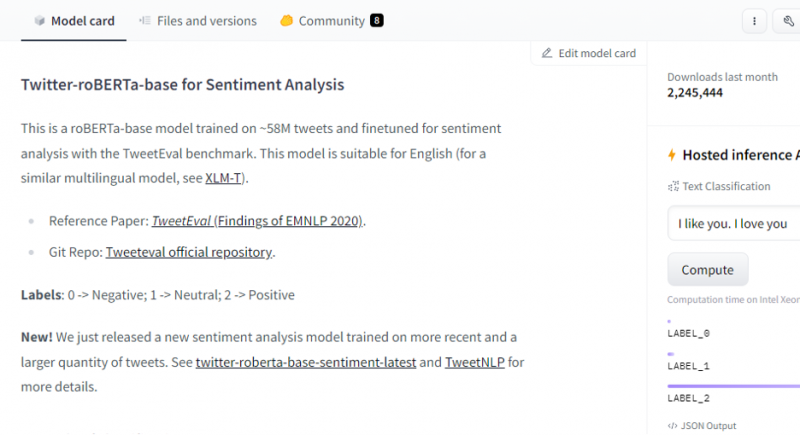

Når du har valgt model, vises dens modelkort. Dette modelkort indeholder information om træningsdetaljerne for modellen og hvilke egenskaber modellen har. Vores model er roBERTa-baseret, som er trænet på 58M tweets til sentimentanalyse. Denne model har tre hovedklasseetiketter, og den kategoriserer hvert input i dets relevante klasseetiketter.

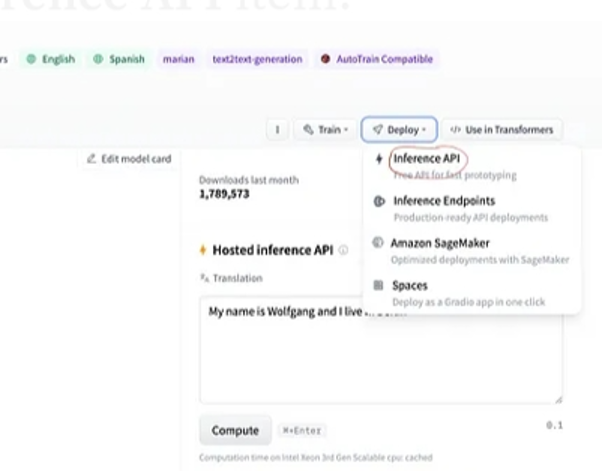

Efter valg af model, hvis vi vælger implementeringsknappen, som er til stede i øverste højre hjørne af vinduet, åbner den en rullemenu. Fra denne menu skal vi vælge indstillingen 'Inference API'.

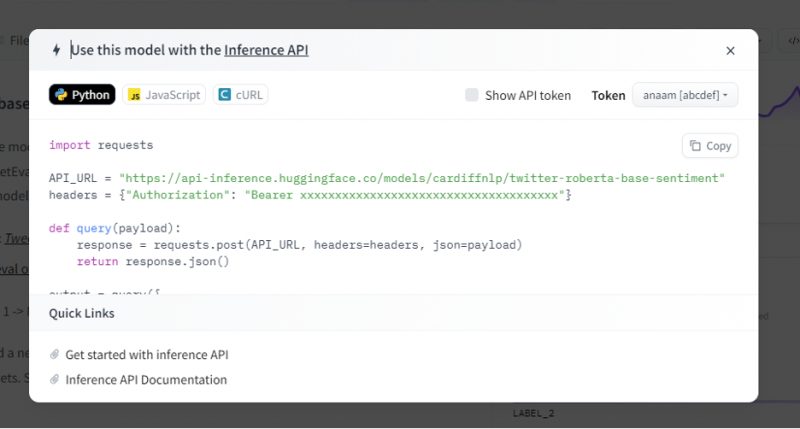

Inferens-API'en giver derefter en hel forklaring på, hvordan man bruger denne specifikke model med denne inferens, og lader os hurtigt skabe prototypen til AI-modellen. Inferens API-vinduet viser koden, der er skrevet i Pythons script.

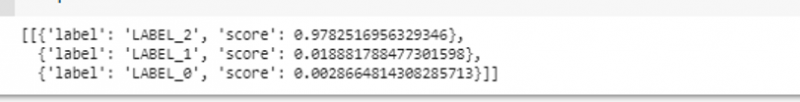

Vi kopierer denne kode og udfører denne kode i enhver af Python IDE. Vi bruger Google Colab til dette. Efter at have udført denne kode i Python-skallen, returnerer den et output, der følger med scoren og etiketten forudsigelse. Denne etiket og score er givet i henhold til vores input, da vi valgte 'tekst-sentimentanalyse'-modellen. Derefter er det input, vi giver til modellen, en positiv sætning, og modellen blev fortrænet på tre etiketklasser: etiket 0 betyder negativ, etiket1 betyder neutral, og etiket 2 er sat til positiv. Da vores input er en positiv sætning, er scoreforudsigelsen fra modellen mere end de to andre etiketter, hvilket betyder, at modellen forudsagde sætningen som en 'positiv'.

importere anmodningerAPI_URL = 'https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment'

overskrifter = { 'Bemyndigelse' : 'Bærer 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' }

def forespørgsel ( nyttelast ) :

respons = anmodninger. stolpe ( API_URL , overskrifter = overskrifter , json = nyttelast )

Vend tilbage respons. json ( )

produktion = forespørgsel ( {

'input' : 'Jeg har det godt, når du er sammen med mig' ,

} )

Produktion:

Eksempel 2: Opsummeringsmodel gennem inferens

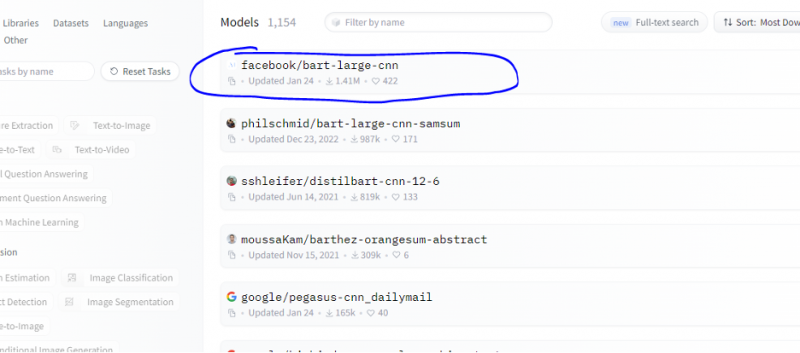

Vi følger de samme trin, som er vist i det foregående eksempel, og prototyper opsummeringsmodelbussen ved hjælp af dens inference API fra Hugging Face. Opsummeringsmodellen er en præ-trænet model, der opsummerer hele teksten, som vi giver den som input. Gå til Hugging Face-kontoen, klik på modellen fra den øverste menulinje, og vælg derefter den model, der er relevant for opsummeringen, vælg den og læs dens modelkort omhyggeligt.

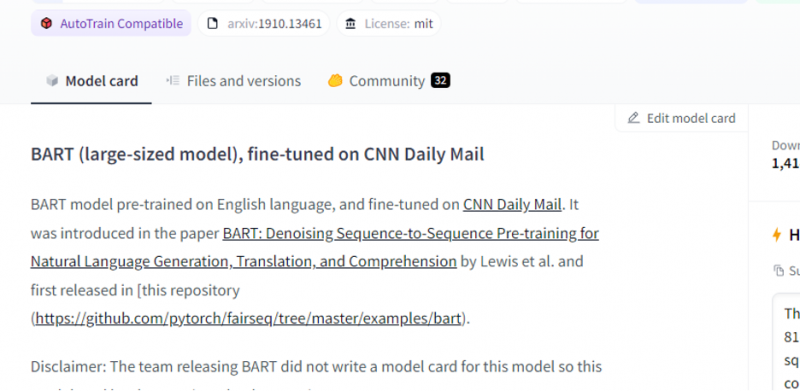

Den model, vi valgte, er en fortrænet BART-model, og den er finjusteret til datasættet CNN-dail mail. BART er en model, som minder mest om BERT-modellen, som har enkoder og dekoder. Denne model er effektiv, når den er finjusteret til forståelse, opsummering, oversættelse og tekstgenereringsopgaver.

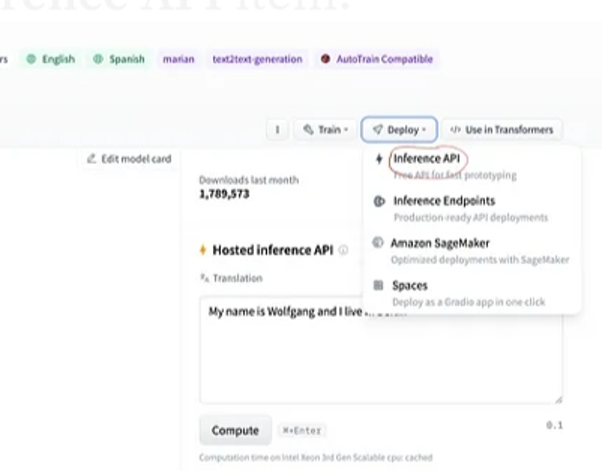

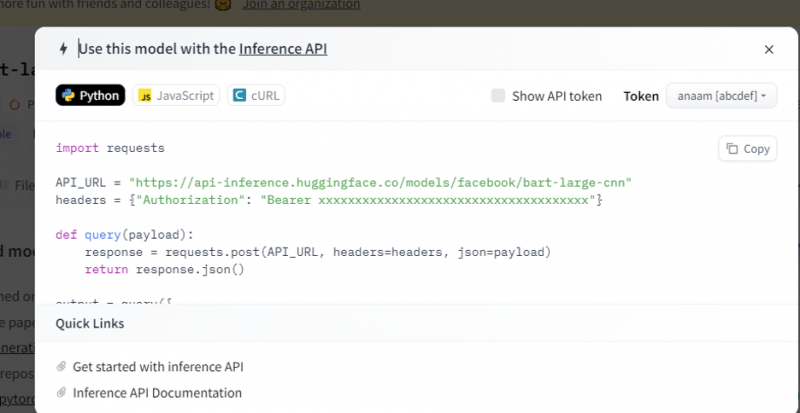

Vælg derefter knappen 'implementering' i øverste højre hjørne, og vælg inferens-API'en fra rullemenuen. Inferens-API'en åbner et andet vindue, der indeholder koden og vejledningen til at bruge denne model med denne inferens.

Kopier denne kode og kør den i en Python-shell.

Modellen returnerer output, som er opsummeringen af input, som vi tilførte den.

Konklusion

Vi arbejdede på Hugging Face Inference API og lærte, hvordan vi kan bruge denne applikations programmerbare grænseflade til at arbejde med de forudtrænede sprogmodeller. De to eksempler, som vi lavede i artiklen, var hovedsageligt baseret på NLP-modellerne. Hugging Face API kan gøre underværker, hvis vi ønsker at udvikle en hurtig prototype ved at levere hurtig integration af AI-modeller i vores applikationer. Kort sagt har Hugging Face løsninger på alle dine problemer fra forstærkningslæring til computersyn.