Dette indlæg vil illustrere processen med at bygge LangChain-applikationer ved hjælp af promptskabelon og outputparser.

Hvordan bygger man LangChain-applikationer ved hjælp af promptskabelon og outputparser?

For at bygge LangChain-applikationen ved hjælp af promptskabelonen og outputparseren skal du blot gennemgå denne nemme vejledning:

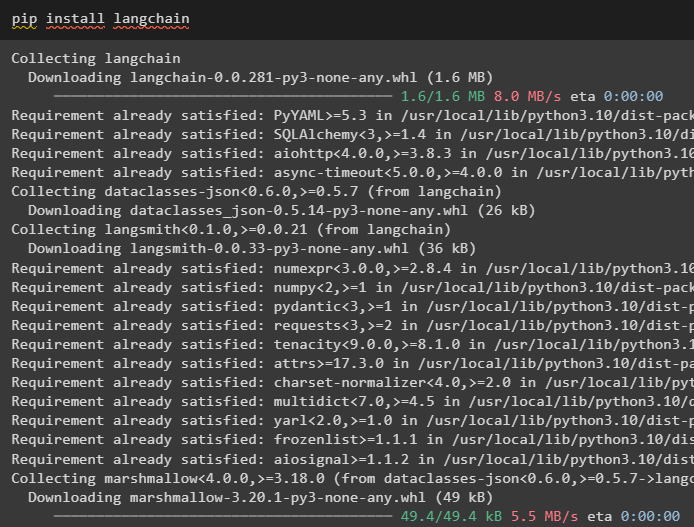

Trin 1: Installer LangChain

Start først processen med at bygge LangChain-applikationer ved at installere LangChain-rammeværket ved hjælp af ' pip kommando:

pip installer langkæde

Trin 2: Brug af promptskabelon

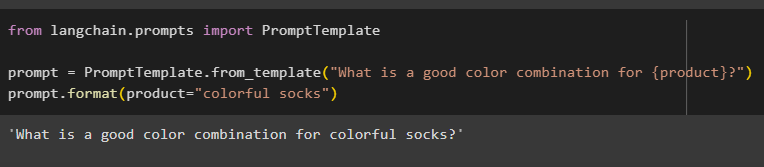

Efter installation af LangChain-modulerne skal du importere ' PromptTemplate ”-bibliotek til at bygge en promptskabelon ved at give en forespørgsel til modellen for at forstå spørgsmålet:

fra langchain.prompts importer PromptTemplate

prompt = PromptTemplate.from_template('Hvad er en god farvekombination for {product}?')

prompt.format(product='farverige sokker')

Outputtet kombinerede automatisk sætningen med værdien af ' produkt variabel:

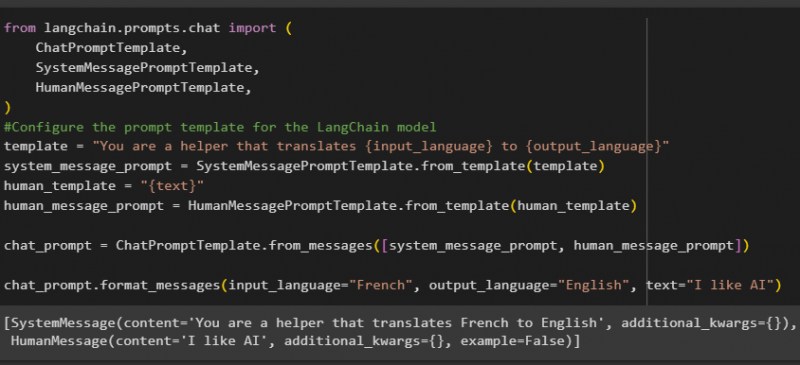

Byg derefter en anden promptskabelon ved at importere HumanMessagePromptTemplate-, ChatPromptTemplate- og SystemMessagePromptTemplate-bibliotekerne fra LangChain:

fra langchain.prompts.chat import (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Konfigurer promptskabelonen for LangChain-modellen

template = 'Du er en hjælper, der oversætter {input_language} til {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(template)

human_template = '{tekst}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='fransk', output_language='engelsk', text='Jeg kan godt lide AI')

Efter at have importeret alle de nødvendige biblioteker, skal du blot konstruere den tilpassede skabelon til forespørgslerne ved hjælp af skabelonvariablen:

Promptskabelonerne bruges kun til at indstille skabelonen for forespørgslen/spørgsmålet, og den svarer ikke med noget svar på spørgsmålet. Men funktionen OutputParser() kan udtrække svar, som det følgende afsnit forklarer med eksemplet:

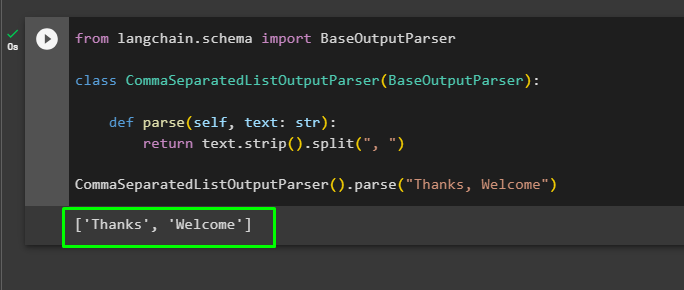

Trin 3: Brug af Output Parser

Importer nu BaseOutputParser-biblioteket fra LangChain for at adskille tekstværdierne adskilt med kommaer og returnere listen i outputtet:

fra langchain.schema import BaseOutputParserklasse CommaSeparatedListOutputParser(BaseOutputParser):

def parse(selv, tekst: str):

returner text.strip().split(', ')

CommaSeparatedListOutputParser().parse('Tak, velkommen')

Det handler om at bygge LangChain-applikationen ved hjælp af promptskabelonen og outputparseren.

Konklusion

For at bygge en LangChain-applikation ved hjælp af promptskabelonen og outputparseren skal du blot installere LangChain og importere biblioteker fra den. PromptTemplate-biblioteket bruges til at bygge strukturen for forespørgslen, så modellen kan forstå spørgsmålet, før den uddrager information ved hjælp af Parser()-funktionen. Funktionen OutputParser() bruges til at hente svar baseret på de tidligere tilpassede forespørgsler. Denne guide har forklaret processen med at bygge LangChain-applikationer ved hjælp af promptskabelonen og outputparseren.