Denne guide vil illustrere processen med at køre LLMChains i LangChain.

Hvordan kører man LLMChains i LangChain?

LangChain giver funktionerne eller afhængighederne til at bygge LLMChains ved hjælp af LLM'er/Chatbots og promptskabeloner. For at lære processen med at bygge og køre LLMChains i LangChain skal du blot følge følgende trinvise vejledning:

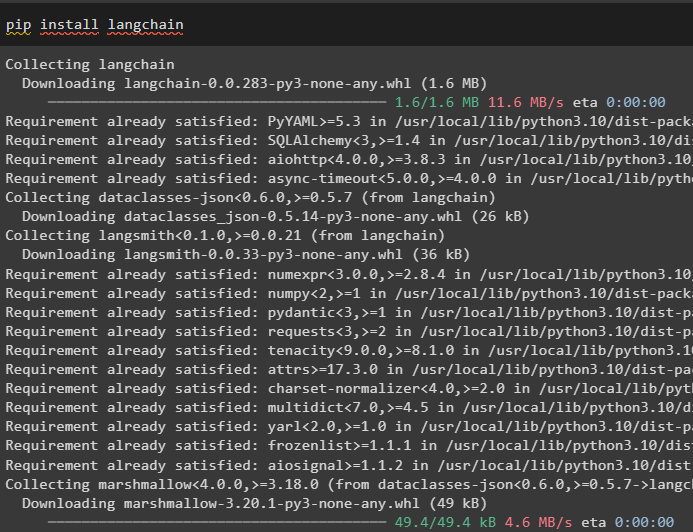

Trin 1: Installer pakker

Først skal du komme i gang med processen ved at installere LangChain-modulet for at få dets afhængigheder til at bygge og køre LLMChains:

pip installer langkæde

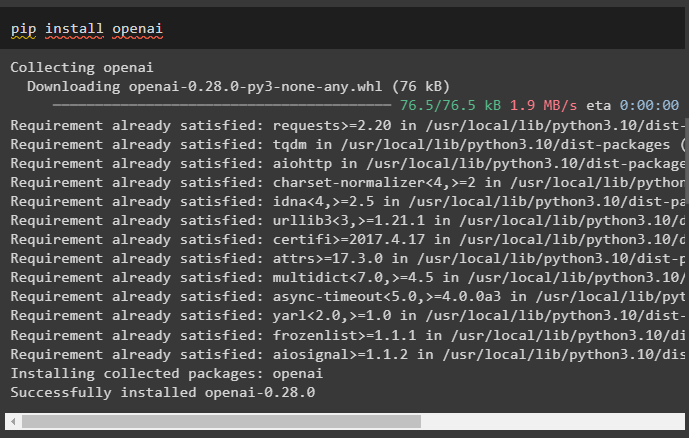

Installer OpenAI-rammen ved hjælp af pip-kommandoen for at få bibliotekerne til at bruge OpenAI()-funktionen til at bygge LLM'er:

pip installer openai

Efter installationen af moduler, simpelthen sætte miljøet op variabler ved hjælp af API-nøglen fra OpenAI-kontoen:

importere du

importere getpass

du . rundt regnet [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'OpenAI API-nøgle:' )

Trin 2: Importer biblioteker

Når opsætningen er fuldført, og alle de nødvendige pakker er installeret, skal du importere de nødvendige biblioteker til opbygning af promptskabelonen. Derefter skal du blot bygge LLM'en ved hjælp af OpenAI()-metoden og konfigurere LLMChain'en ved hjælp af LLM'erne og promptskabelonen:

fra langkæde importere PromptTemplatefra langkæde importere OpenAI

fra langkæde importere LLMChain

prompt_skabelon = 'giv mig en god titel for en virksomhed, der laver {produkt}?'

llm = OpenAI ( temperatur = 0 )

llm_kæde = LLMChain (

llm = llm ,

hurtig = PromptTemplate. fra_skabelon ( prompt_skabelon )

)

llm_kæde ( 'farverigt tøj' )

Trin 3: Løb kæder

Få inputlisten, der indeholder forskellige produkter produceret af virksomheden, og kør kæden for at vise listen på skærmen:

input_list = [{ 'produkt' : 'sokker' } ,

{ 'produkt' : 'computer' } ,

{ 'produkt' : 'sko' }

]

llm_kæde. ansøge ( input_list )

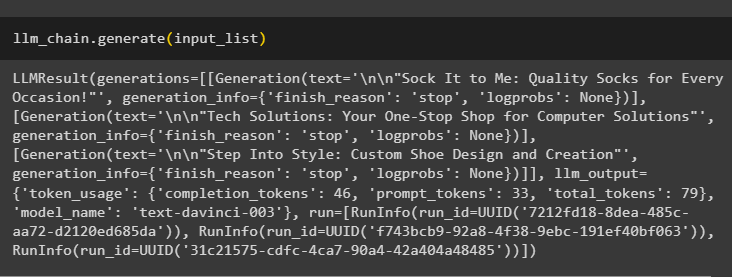

Kør gener()-metoden ved hjælp af input_list med LLMChains for at få output relateret til samtalen genereret af modellen:

llm_kæde. frembringe ( input_list )

Trin 4: Brug af enkelt input

Tilføj et andet produkt for at køre LLMChains ved kun at bruge et enkelt input og forudsige derefter LLMChain for at generere output:

llm_kæde. forudsige ( produkt = 'farverige sokker' )Trin 5: Brug af flere indgange

Byg nu skabelonen til brug af flere input til at levere kommandoen til modellen, før du kører kæden:

skabelon = '''Fortæl mig en {adjektiv} joke om {emne}.'''hurtig = PromptTemplate ( skabelon = skabelon , input_variables = [ 'adjektiv' , 'emne' ] )

llm_kæde = LLMChain ( hurtig = hurtig , llm = OpenAI ( temperatur = 0 ) )

llm_kæde. forudsige ( adjektiv = 'trist' , emne = 'ænder' )

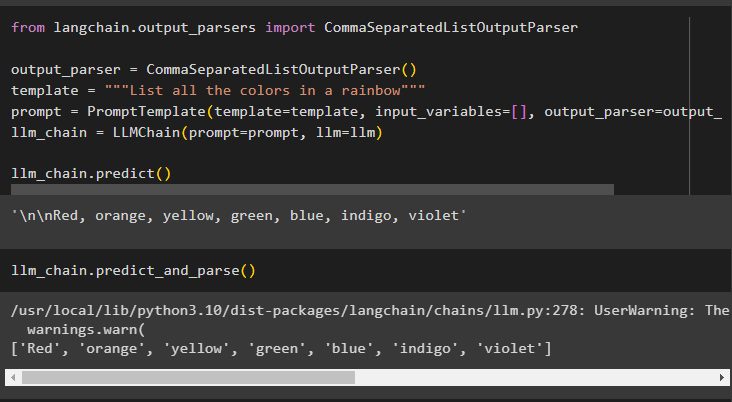

Trin 6: Brug af Output Parser

Dette trin bruger output-parsermetoden til at køre LLMChain for at få output baseret på prompten:

fra langkæde. output_parsere importere CommaSeparatedListOutputParseroutput_parser = CommaSeparatedListOutputParser ( )

skabelon = '''List alle farverne i en regnbue'''

hurtig = PromptTemplate ( skabelon = skabelon , input_variables = [ ] , output_parser = output_parser )

llm_kæde = LLMChain ( hurtig = hurtig , llm = llm )

llm_kæde. forudsige ( )

Brug af metoden parse() til at få output vil generere en kommasepareret liste over alle farverne i regnbuen:

llm_kæde. forudsige_og_parse ( )

Trin 7: Initialisering fra strenge

Dette trin forklarer processen med at bruge en streng som prompt for at køre LLMChain ved hjælp af LLM-modellen og skabelonen:

skabelon = '''Fortæl mig en {adjektiv} joke om {subject}'''llm_kæde = LLMChain. fra_streng ( llm = llm , skabelon = skabelon )

Angiv værdierne for variablerne i strengprompten for at få output fra modellen ved at køre LLMChain:

llm_kæde. forudsige ( adjektiv = 'trist' , emne = 'ænder' )Det handler om at køre LLMChains ved hjælp af LangChain-rammerne.

Konklusion

For at bygge og køre LLMChains i LangChain skal du installere forudsætningerne som pakker og opsætte miljøet ved hjælp af OpenAI's API-nøgle. Importer derefter de nødvendige biblioteker til konfiguration af promptskabelonen og modellen til at køre LLMChain ved hjælp af LangChain-afhængighederne. Brugeren kan bruge outputparsere og strengkommandoer til at køre LLMChains som vist i vejledningen. Denne guide har uddybet hele processen med at køre LLMChains i LangChain.