Anvendeligheden og anvendeligheden af Machine Learning-modeller testes på data. Testenes pålidelighed afhænger i høj grad af mængden og kvaliteten af de data, som disse modeller anvendes på. Det er en komplet opgave i sig selv at skabe, skaffe og rense et passende stort datasæt for at teste din ' Naturlig sprogbehandling (NLP) ” Machine Learning model.

Hugging Face tilbyder en smart løsning til dette med sit usædvanligt store bibliotek af datasæt at vælge imellem og finde det, der passer perfekt til dine krav. Her vil vi vise dig, hvordan du finder det ideelle datasæt og forbereder det til at teste din model tilstrækkeligt.

Hvordan man bruger Hugging Face-datasæt?

Vi vil vise dig, hvordan du bruger Hugging Face-datasæt ved at bruge eksemplet med ' TinyStories ” Datasæt fra Hugging Face.

Eksempel

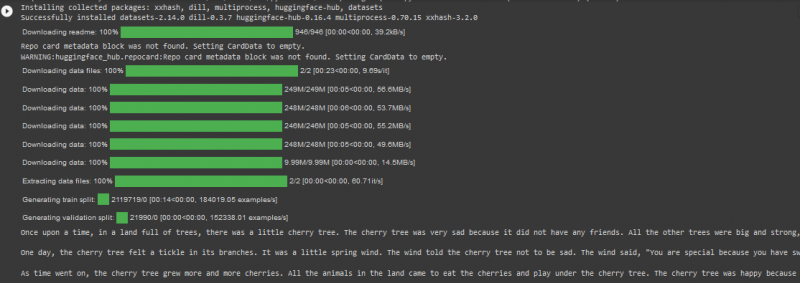

TinyStories-datasættet har mere end 2 millioner rækker af data i togopdelingen, og det har mere end 2 tusinde downloads på Hugging Face-platformen. Vi vil bruge det i koden i Google Colab, der er angivet nedenfor:

! pip installere transformere

! pip installere datasæt

fra datasæt importer load_dataset

datasæt = load_dataset ( 'roneneldan/TinyStories' )

TinyStories_Story = 3

eksempel_streng = datasæt [ 'tog' ] [ TinyStories_Story ] [ 'tekst' ]

Print ( eksempel_streng )

Overvej nedenstående trin i denne kode:

Trin 01 : Det første trin er ' installation ” af transformatordatasæt.

Trin 02 : Importer derefter det nødvendige datasæt, ' TinyStories ” ind i dit projekt.

Trin 03 : Indlæs derefter det valgte datasæt ved hjælp af ' load_dataset() ' funktion.

Trin 04 : Nu angiver vi det historienummer, vi ønsker fra TinyStories-datasættet. Vi har specificeret tallet 03 i vores kodeeksempel.

Trin 05 : Til sidst vil vi bruge metoden 'print()' til at vise outputtet.

Produktion

Bemærk: Koden og outputtet kan også ses direkte i vores Google Colab .

Konklusion

“ Knusende ansigt-datasæt ” gør det utroligt effektivt for brugere at teste deres Machine Learning-modeller, mens de direkte importerer store datasæt fra deres online-bibliotek. Som et resultat er anvendelsen af NLP-algoritmer blevet nemmere og hurtigere, da programmører er i stand til at få deres projekter testet mod et datasæt, der har både kvalitet og kvantitet.