I denne blog vil vi fokusere på de måder, hvorpå du kan øge GPU-udnyttelsen i PyTorch.

Sådan øges GPU-udnyttelsen i PyTorch?

Der er flere teknikker, der kan bruges til at øge GPU-udnyttelsen og sikre, at de bedste hardwareressourcer bliver brugt til behandlingen af komplekse maskinlæringsmodeller. Disse taktikker involverer redigering af koden og brug af PyTorch-funktioner. Nogle vigtige tips og tricks er listet nedenfor:

- Indlæsning af data og batchstørrelser

- Mindre hukommelsesafhængige modeller

- PyTorch Lightning

- Juster Runtime Settings i Google Colab

- Ryd cache for optimering

Indlæsning af data og batchstørrelser

Det ' Dataloader ” i PyTorch bruges til at definere specifikationerne for de data, der skal indlæses i processoren med hver fremadgående pass af deep learning-modellen. En større' batch størrelse ” af data vil kræve mere processorkraft og vil øge udnyttelsen af den tilgængelige GPU.

Syntaksen for at tildele en Dataloader med en specifik batchstørrelse i PyTorch til en brugerdefineret variabel er angivet nedenfor:

Increase_GPU_Utilization = DataLoader ( batch_size = 32 )

Mindre hukommelsesafhængige modeller

Hver modelarkitektur kræver en anden mængde ' hukommelse ” at præstere på sit optimale niveau. Modeller, der er effektive til at bruge mindre hukommelse pr. tidsenhed, er i stand til at arbejde med batchstørrelser, der er langt større end andres.

PyTorch Lightning

PyTorch har en nedskaleret version, der er ' PyTorch Lightning '. Den er optimeret til lynhurtig ydeevne, som det kan ses af navnet. Lightning bruger som standard GPU'er og tilbyder meget hurtigere behandling til maskinlæringsmodeller. En stor fordel ved Lightning er manglen på krav om boilerplate-kode, der kan hæmme behandlingen.

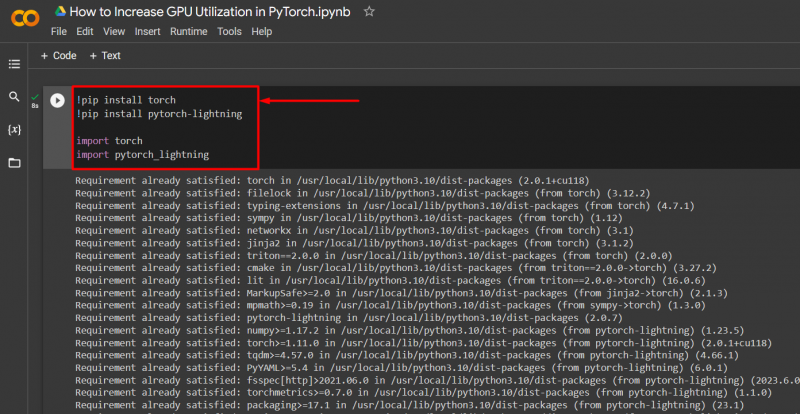

Importer de nødvendige biblioteker til et PyTorch-projekt med syntaksen nedenfor:

! pip-installationsbrænder

! pip install pytorch - lyn

importere fakkel

importere pytorch_lyn

Juster Runtime Settings i Google Colab

Google Colaboratory er en cloud-IDE, der giver gratis GPU-adgang til sine brugere til udvikling af PyTorch-modeller. Som standard kører Colab-projekterne på CPU, men indstillingerne kan ændres.

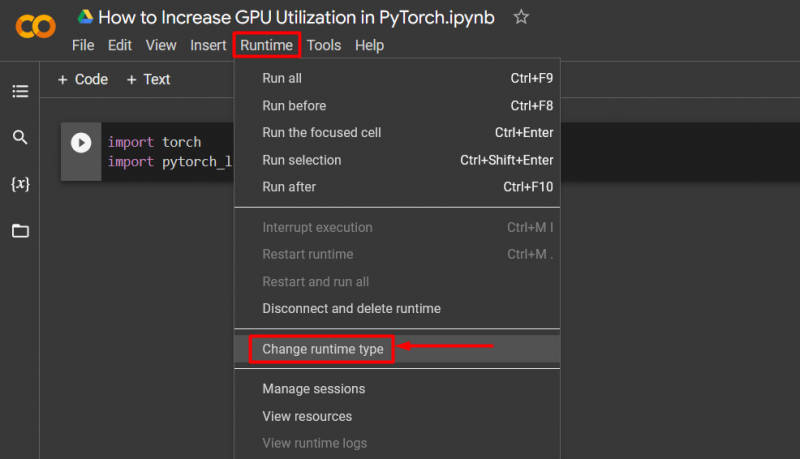

Åbn Colab-notesbogen, gå til ' Runtime ' i menulinjen, og rul ned til ' Skift køretidsindstillinger ”:

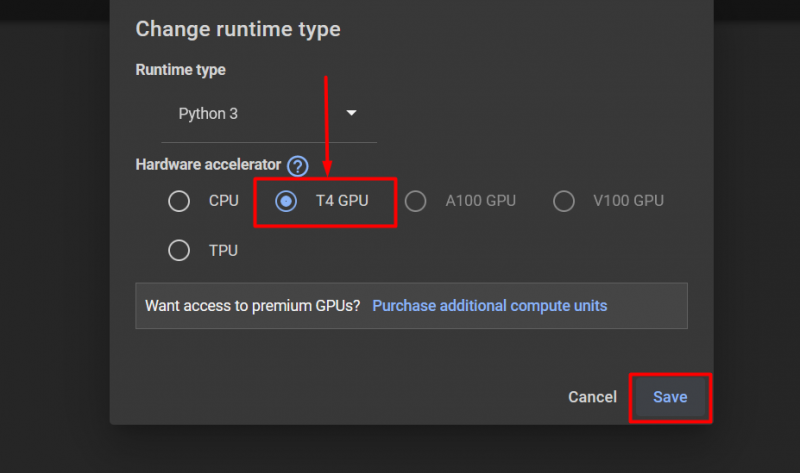

Vælg derefter 'T4 GPU' mulighed og klik på ' Gemme ' for at anvende ændringerne for at bruge GPU:

Ryd cache for optimering

PyTorch giver sine brugere mulighed for at rydde hukommelsescachen for at kunne frigøre plads til nye processer. Det ' Cache ” gemmer data og information om de modeller, der køres, så det kan spare tid, der vil blive brugt på at genindlæse disse modeller. Rydning af cachen giver brugerne mere plads til at køre nye modeller.

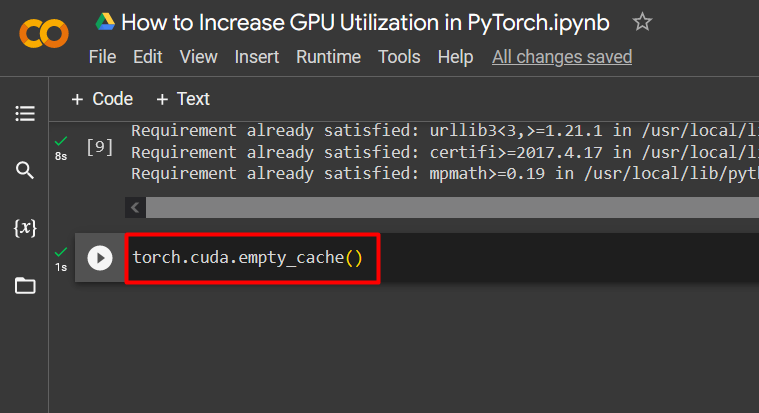

Kommandoen til at rydde GPU-cachen er givet nedenfor:

fakkel. forskellige . tomme_cache ( )

Disse tips bruges til at optimere driften af maskinlæringsmodeller med GPU'er i PyTorch.

Pro-Tip

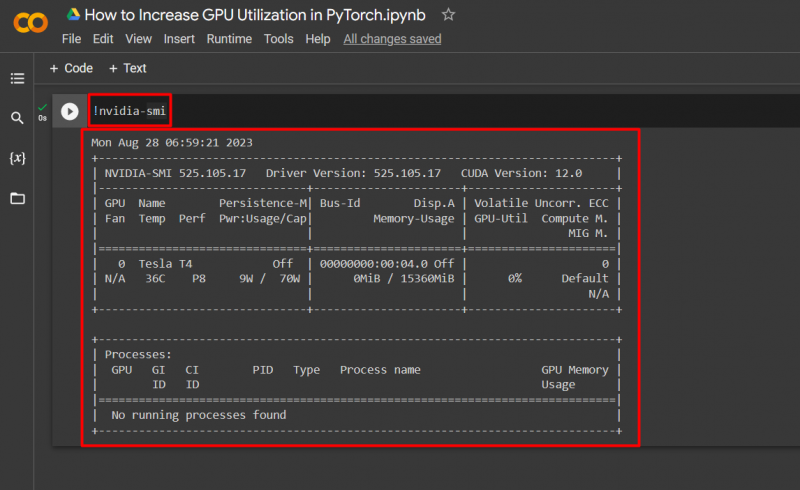

Google Colab giver sine brugere adgang til detaljer om GPU-udnyttelse ved at ' nvidia ” for at få information om, hvor hardwareressourcerne bliver brugt. Kommandoen til at vise GPU-brugsdetaljerne er givet nedenfor:

! nvidia - smi

Succes! Vi har lige demonstreret et par måder at øge GPU-udnyttelsen i PyTorch.

Konklusion

Forøg GPU-udnyttelsen i PyTorch ved at slette cache, bruge PyTorch Lightning, justere runtime-indstillinger, bruge effektive modeller og optimale batchstørrelser. Disse teknikker går langt i at sikre, at de dybe læringsmodeller yder deres bedste og er i stand til at drage valide konklusioner og slutninger fra de tilgængelige data. Vi har demonstreret teknikkerne til at øge GPU-udnyttelsen.