'Datasæt'-biblioteket fra Hugging Face giver en bekvem måde at arbejde med og manipulere datasættene til naturlige sprogbehandlingsopgaver. En nyttig funktion, der tilbydes af biblioteket, er concatenate_datasets(), som giver dig mulighed for at sammenkæde flere datasæt til et enkelt datasæt. Det følgende er en kort oversigt over funktionen concatenate_datasets() og hvordan den bruges.

concatenate_datasets()

Beskrivelse:

Hugging Faces 'datasets'-bibliotek giver funktionen concatenate_datasets() . Det bruges til at sammenkæde flere datasæt ved at kombinere dem til et enkelt datasæt langs en specificeret akse. Denne funktion er især nyttig, når du har flere datasæt, der deler den samme struktur, og du ønsker at flette dem til et samlet datasæt til yderligere behandling og analyse.

Syntaks:

fra datasæt importere sammenkæde_datasæt

sammenkædet_datasæt = sammenkæde_datasæt ( datasæt , akse = 0 , info = Ingen )

Parametre:

datasæt (liste over datasæt): En liste over datasæt, som du ønsker at sammenkæde. Disse datasæt skal have kompatible funktioner, hvilket betyder, at de har samme skema, kolonnenavne og datatyper.

akse (int, optional, default=0): Den akse, langs hvilken sammenkædningen skal udføres. For de fleste NLP-datasæt bruges standardværdien 0, hvilket betyder, at datasættene er sammenkædet lodret. Hvis du indstiller aksen=1, er datasættene sammenkædet vandret, forudsat at de har forskellige kolonner som funktioner.

info (datasets.DatasetInfo, valgfri): Oplysningerne om det sammenkædede datasæt. Hvis den ikke er angivet, udledes oplysningerne fra det første datasæt på listen.

Vender tilbage:

sammenkædet_datasæt (Datasæt): Det resulterende datasæt efter sammenkædning af alle inputdatasæt.

Eksempel:

# Trin 1: Installer datasætbiblioteket# Du kan installere det ved hjælp af pip:

# !pip installationsdatasæt

# Trin 2: Importer nødvendige biblioteker

fra datasæt importere load_dataset , sammenkæde_datasæt

# Trin 3: Indlæs IMDb-filmanmeldelsesdatasæt

# Vi bruger to IMDb-datasæt, et til positive anmeldelser

#og en anden for negative anmeldelser.

# Indlæs 2500 positive anmeldelser

dataset_pos = load_dataset ( 'imdb' , dele = 'tog[:2500]' )

# Indlæs 2500 negative anmeldelser

dataset_neg = load_dataset ( 'imdb' , dele = 'tog[-2500:]' )

# Trin 4: Sammenkæd datasættene

# Vi sammenkæder begge datasæt langs akse=0, som de har

samme skema ( samme funktioner ) .

sammenkædet_datasæt = sammenkæde_datasæt ( [ dataset_pos , dataset_neg ] )

# Trin 5: Analyser det sammenkædede datasæt

# For nemheds skyld, lad os tælle antallet af positive og negative

# anmeldelser i det sammenkædede datasæt.

antal_positive_anmeldelser = sum ( 1 til etiket i

sammenkædet_datasæt [ 'etiket' ] hvis etiket == 1 )

antal_negative_anmeldelser = sum ( 1 til etiket i

sammenkædet_datasæt [ 'etiket' ] hvis etiket == 0 )

# Trin 6: Vis resultaterne

Print ( 'Antal positive anmeldelser:' , antal_positive_anmeldelser )

Print ( 'Antal negative anmeldelser:' , antal_negative_anmeldelser )

# Trin 7: Udskriv et par eksempler på anmeldelser fra det sammenkædede datasæt

Print ( ' \n Nogle eksempler på anmeldelser:' )

til jeg i rækkevidde ( 5 ) :

Print ( f 'Gennemgå {i + 1}: {concatenated_dataset['text'][i]}' )

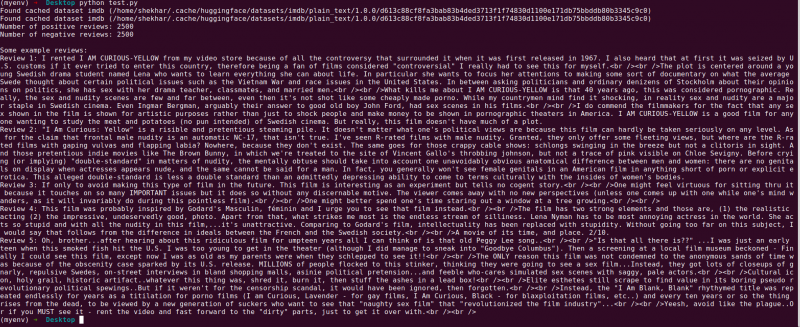

Produktion:

Det følgende er forklaringen på Hugging Faces 'datasæt'-biblioteksprogram, der sammenkæder to IMDb-filmanmeldelsesdatasæt. Dette forklarer formålet med programmet, dets brug og de trin, der er involveret i koden.

Lad os give en mere detaljeret forklaring af hvert trin i koden:

# Trin 1: Importer nødvendige bibliotekerfra datasæt importere load_dataset , sammenkæde_datasæt

I dette trin importerer vi de nødvendige biblioteker til programmet. Vi har brug for funktionen 'load_dataset' for at indlæse IMDb-filmanmeldelsesdatasættene, og 'concatenate_datasets' for at sammenkæde dem senere.

# Trin 2: Indlæs IMDb Movie Review Datasæt# Indlæs 2500 positive anmeldelser

dataset_pos = load_dataset ( 'imdb' , dele = 'tog[:2500]' )

# Indlæs 2500 negative anmeldelser

dataset_neg = load_dataset ( 'imdb' , dele = 'tog[-2500:]' )

Her bruger vi funktionen 'load_dataset' til at hente to undersæt af IMDb-datasættet. 'dataset_pos' har 2500 positive anmeldelser og 'dataset_neg' indeholder 2500 negative anmeldelser. Vi bruger split-parameteren til at angive rækken af eksempler, der skal indlæses, hvilket giver os mulighed for at vælge en delmængde af hele datasættet.

# Trin 3: Sammenkæd datasættenesammenkædet_datasæt = sammenkæde_datasæt ( [ dataset_pos , dataset_neg ] )

I dette trin sammenkæder vi de to undersæt af IMDb-datasættet til et enkelt datasæt kaldet 'concatenated_dataset'. Vi bruger funktionen 'sammenkædning_datasæt' og sender den med en liste, der indeholder de to datasæt, der skal sammenkædes. Da begge datasæt har de samme funktioner, sammenkæder vi dem langs akse=0, hvilket betyder, at rækkerne er stablet oven på hinanden.

# Trin 4: Analyser det sammenkædede datasætantal_positive_anmeldelser = sum ( 1 til etiket i

sammenkædet_datasæt [ 'etiket' ] hvis etiket == 1 )

antal_negative_anmeldelser = sum ( 1 til etiket i

sammenkædet_datasæt [ 'etiket' ] hvis etiket == 0 )

Her udfører vi en simpel analyse af det sammenkædede datasæt. Vi bruger listeforståelsen sammen med 'sum'-funktionen til at tælle antallet af positive og negative anmeldelser. Vi itererer gennem “ label'-kolonnen i 'sammenkædet_datasæt' og øge antallet, når vi støder på en positiv etiket (1) eller en negativ etiket (0).

# Trin 5: Vis resultaternePrint ( 'Antal positive anmeldelser:' , antal_positive_anmeldelser )

Print ( 'Antal negative anmeldelser:' , antal_negative_anmeldelser )

I dette trin udskriver vi resultaterne af vores analyse – antallet af positive og negative anmeldelser i det sammenkædede datasæt.

# Trin 6: Udskriv et par eksempler på anmeldelserPrint ( ' \n Nogle eksempler på anmeldelser:' )

til jeg i rækkevidde ( 5 ) :

Print ( f 'Gennemgå {i + 1}: {concatenated_dataset['text'][i]}' )

Til sidst viser vi et par eksempler på anmeldelser fra det sammenkædede datasæt. Vi går gennem de første fem eksempler i datasættet og udskriver deres tekstindhold ved hjælp af 'tekst'-kolonnen.

Denne kode demonstrerer et ligetil eksempel på brug af Hugging Faces 'datasæt'-bibliotek til at indlæse, sammenkæde og analysere IMDb-filmanmeldelsesdatasæt. Det fremhæver bibliotekets evne til at strømline NLP-datasæthåndteringen og viser dets potentiale til at bygge mere sofistikerede modeller og applikationer til behandling af naturligt sprog.

Konklusion

Python-programmet, der bruger Hugging Faces 'datasæt'-bibliotek, demonstrerer med succes sammenkædningen af to IMDb-filmanmeldelsesdatasæt. Ved at indlæse undersættene af positive og negative anmeldelser kombinerer programmet dem til et enkelt datasæt ved hjælp af concatenate_datasets()-funktionen. Den laver derefter en simpel analyse ved at tælle antallet af positive og negative anmeldelser i det kombinerede datasæt.

'Datasæt'-biblioteket forenkler processen med at håndtere og manipulere NLP-datasættene, hvilket gør det til et stærkt værktøj for forskere, udviklere og NLP-udøvere. Med sin brugervenlige grænseflade og omfattende funktionaliteter muliggør biblioteket en ubesværet dataforbehandling, udforskning og transformation. Programmet, der er vist i denne dokumentation, tjener som et praktisk eksempel på, hvordan biblioteket kan udnyttes til at strømline datasammenkædning og analyseopgaver.

I virkelige scenarier kan dette program tjene som grundlag for mere komplekse naturlige sprogbehandlingsopgaver såsom sentimentanalyse, tekstklassificering og sprogmodellering. Ved at bruge 'datasæt'-biblioteket kan forskere og udviklere effektivt administrere de store datasæt, lette eksperimenter og fremskynde udviklingen af avancerede NLP-modeller. Samlet set står Hugging Face 'datasæt'-biblioteket som et væsentligt aktiv i jagten på fremskridt inden for naturlig sprogbehandling og -forståelse.