I denne æra er Transformers de mest kraftfulde modeller, der har givet de bedste resultater i flere NLP-operationer (Natural Language Processing). Oprindeligt blev det brugt til sprogmodelleringsopgaver, herunder tekstgenerering samt klassificering, maskinoversættelse og mange flere. Men nu bruges det også til objektgenkendelse, billedklassificering og flere andre computersynsopgaver.

I denne vejledning vil vi give proceduren til at udføre tekstklassificeringen ved hjælp af Transformers.

Hvordan udfører man tekstklassificering ved hjælp af transformere?

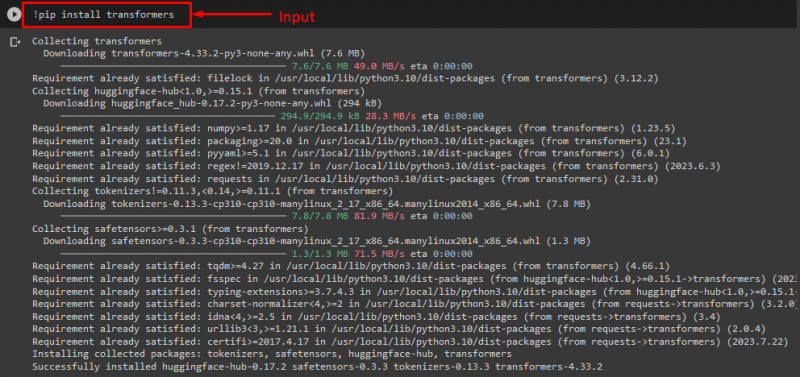

For at udføre tekstklassificeringen ved hjælp af Transformers skal du først og fremmest installere ' transformere ” bibliotek ved at udføre den angivne kommando:

! pip installere transformere

Som du kan se, er det angivne bibliotek blevet installeret med succes:

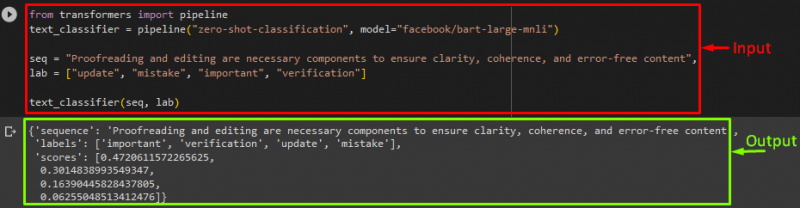

Importer derefter ' rørledning ' fra ' transformere ” bibliotek:

fra transformere importrørledning

Her er ' rørledning ” vil inkludere den NLP-opgave, vi skal udføre, og den ønskede transformermodel for denne operation sammen med tokenizeren.

Bemærk: Tokenizeren bruges til at udføre bearbejdning af teksten, der skal leveres til modellens input ved at adskille tekst i tokens.

Brug derefter ' pipeline() '-funktionen og send den til ' nul-skud-klassificering ” som argument. Send derefter en anden parameter, som er vores model. Vi bruger Facebooks ' BART ” transformer model. Her bruger vi ikke tokenizeren, fordi den automatisk kan udledes af den angivne model:

text_classifier = pipeline ( 'zero-shot-classification' , model = 'facebook/bart-large-mnli' )

Erklær nu ' seq variabel, der indeholder vores inputtekst, som skal klassificeres. Derefter giver vi de kategorier, som vi ønsker at klassificere teksten i og gemme i ' lab ' som er kendt som etiketter:

lab = [ 'opdatering' , 'fejl' , 'vigtig' , 'verifikation' ]

Kør til sidst pipelinen sammen med inputtet:

Efter at have udført pipelinen, som du kan se, forudsagde modellen vores leverede sekvens til at blive klassificeret:

Yderligere Information: Hvis du vil fremskynde modellens ydeevne, skal du bruge GPU'en. Hvis ja, så til det formål kan du angive et enhedsargument til pipelinen og indstille det til ' 0 ' for at bruge GPU'en.

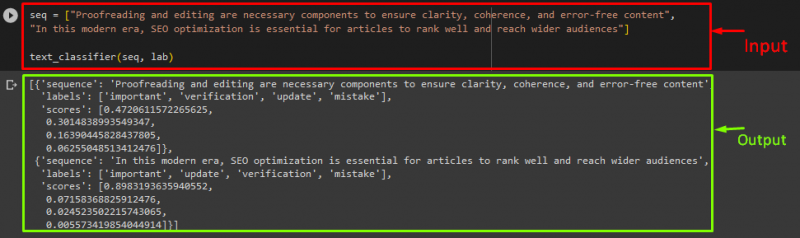

Hvis du ønsker at klassificere teksten på mere end én sekvens/input tekst-sætning, så kan du tilføje dem til en liste og sende den som input til pipelines. Til det formål, tjek kodestykket:

seq = [ 'Korrekturlæsning og redigering er nødvendige komponenter for at sikre klarhed, sammenhæng og fejlfrit indhold' ,'I denne moderne æra er SEO-optimering afgørende for, at artikler kan rangere godt og nå ud til bredere målgrupper' ]

tekstklassifikator ( seq , lab )

Produktion

Det er det! Vi har samlet den nemmeste måde at udføre tekstklassificeringen ved hjælp af Transformers.

Konklusion

Transformere bruges til at udføre sprogmodelleringsopgaver, såsom tekstgenerering, tekstklassificering og maskinoversættelse, såvel som computervisionsopgaver, herunder objektgenkendelse og billedklassificering. I denne vejledning har vi illustreret processen til at udføre tekstklassificering ved hjælp af Transformers.