Funktionen pipeline() er en integreret del af Transformer-biblioteket. Det kræver flere input, hvor vi kan definere en slutningsopgave, modeller, tokeniseringsmekanisme osv. En pipeline()-funktion bruges hovedsageligt til at udføre NLP-opgaver på en eller flere tekster. Den udfører forbehandling af input og efterbehandling baseret på modellen for at generere menneskelæsbart output og nøjagtig forudsigelse med maksimal nøjagtighed.

Denne artikel dækker følgende aspekter:

- Hvad er datasætbiblioteket for Hugging Face?

- Hvordan anvender man rørledninger på et datasæt i Hugging Face?

Hvad er Hugging Face Dataset Library?

Et Hugging Face-datasætbibliotek er en API, der indeholder flere offentlige datasæt og giver en nem måde at downloade dem på. Dette bibliotek kan importeres og installeres i applikationen ved at bruge ' pip ” kommando. Besøg dette for en praktisk demonstration af download og installation af datasæt fra Hugging Face-biblioteket Google Colab link. Du kan downloade flere datasæt fra Krammer Face Dataset Hub.

Lær mere om funktionen af pipeline()-funktionen ved at henvise til denne artikel ' Hvordan bruger man Pipeline()-funktionen i transformere? '.

Hvordan anvender man rørledninger på et datasæt i Hugging Face?

Hugging Face giver flere forskellige offentlige datasæt, der nemt kan installeres ved at bruge en-linje kode. I denne artikel vil vi se en praktisk demonstration af anvendelse af pipelines til disse datasæt. Der er to måder, hvorpå pipelines kan implementeres på datasættet.

Metode 1: Brug af iterationsmetode

Funktionen pipeline() kan også itereres over et datasæt og en model. Til dette formål skal du følge nedenstående trin:

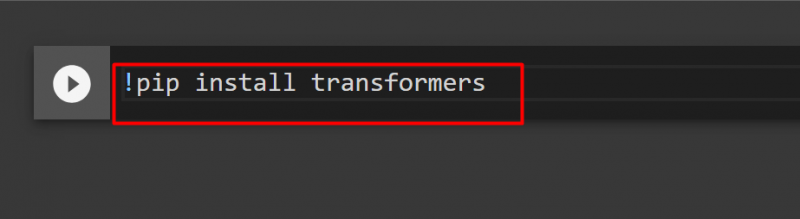

Trin 1: Installer Transformer Library

For at installere Transformer-biblioteket skal du angive følgende kommando:

!pip installere transformere

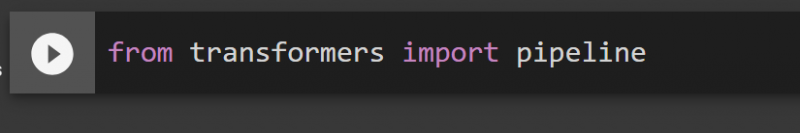

Trin 2: Importer rørledninger

Vi kan importere pipelinen fra Transformer-biblioteket. Til dette formål skal du angive følgende kommando:

fra transformere importrørledning

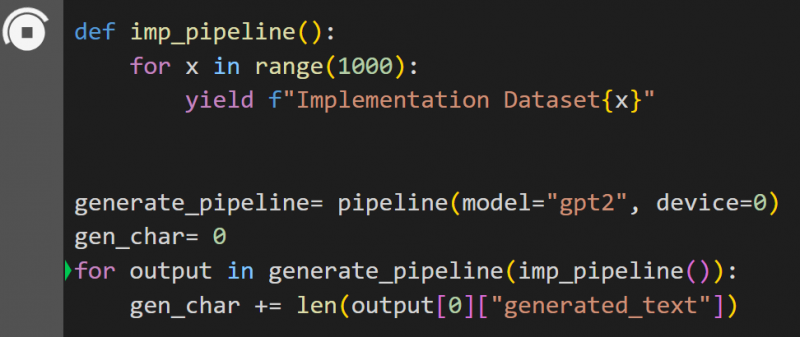

Trin 3: Implementer Pipeline

Her er pipeline()-funktionen implementeret på modellen ' gpt2 ”. Du kan downloade modeller fra Hugging Face Model Hub:

def imp_pipeline():for x i området (1000):

udbytte f'Implementeringsdatasæt{x}'

gener_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

for output i gener_pipeline(imp_pipeline()):

gen_char += len(output[0]['genereret_tekst'])

I denne kode er ' generere_pipeline ' er en variabel, der indeholder pipeline()-funktionen med model ' gpt2 ”. Når det kaldes med ' imp_pipeline() ”-funktionen genkender den automatisk de data, der øges med det angivne område til 1000:

Dette vil tage noget tid at træne. Linket til Google Co er også givet.

Metode 2: Brug af datasætbibliotek

I denne metode vil vi demonstrere implementering af pipelinen ved hjælp af 'datasæt'-biblioteket:

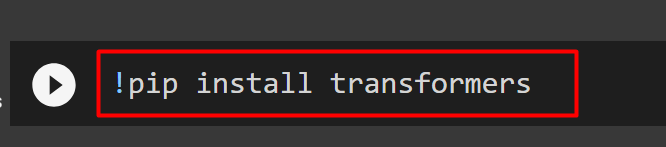

Trin 1: Installer Transformer

For at installere Transformer-biblioteket skal du angive følgende kommando:

!pip installere transformere

Trin 2: Installer datasætbibliotek

Som ' datasæt ” biblioteket indeholder alle de offentlige datasæt, vi kan installere det ved at bruge følgende kommando. Ved at installere ' datasæt ”-bibliotek, kan vi importere ethvert datasæt direkte ved at angive dets navn:

!pip installationsdatasæt

Trin 3: Datasæt Pipeline

For at bygge en pipeline på datasættet skal du bruge følgende kode. KeyDataset er en funktion, der kun udsender de værdier, der interesserer brugeren:

fra transformers.pipelines.pt_utils importer KeyDatasetfra transformere importrørledning

fra datasæt importer load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')til output i gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Udskriver output nu')

Print ('----------------')

print (output)

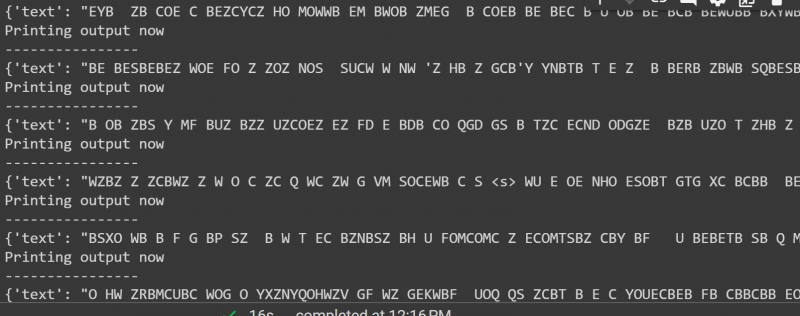

Outputtet af ovenstående kode er givet nedenfor:

Det er alt fra denne guide. Linket til Google Co er også nævnt i denne artikel

Konklusion

For at anvende pipelines på datasættet kan vi enten iterere over et datasæt ved at bruge en pipeline() funktion eller bruge ' datasæt ” bibliotek. Hugging Face giver GitHub-lageret linket til sine brugere for både datasæt og modeller, som kan bruges baseret på kravene. Denne artikel har givet en omfattende guide til anvendelse af pipelines på et datasæt i Transformers.