Syntaks:

Som vi er bekendt med ChatGPT, ved vi, at denne platform ejes af Open AI-fællesskabet, og den giver værktøjer, arkitekturer, API'er og adskillige rammer, som vi kan bruge i implementeringen af vores applikationer og de naturlige sprogbehandlingsmodeller. Open AI tilbyder de API'er, hvorigennem vi kan bruge alle forudtrænede AI- og NLP-modeller fra Open AI-platformen og kan få dem til at fungere for vores applikationer, som for eksempel at give forudsigelser om realtidsdata. Ligeledes giver GPT4All også sine brugere til at integrere sine præ-trænede AI-modeller med forskellige applikationer.

GPT4All-modellen er trænet på begrænsede data sammenlignet med ChatGPT. Det har også nogle af dets præstationsbegrænsninger sammenlignet med ChatGPT, men det giver brugeren mulighed for at bruge deres private GPT på deres lokale hardware, og det kræver ingen netværksforbindelser. Ved hjælp af denne artikel får vi at vide, hvordan vi kan bruge GPT4All-modellerne i Python-scriptet, da GPT4All har de officielle bindinger med Python, hvilket betyder, at vi også kan bruge og integrere GPT4All-modellerne gennem Python-scriptet.

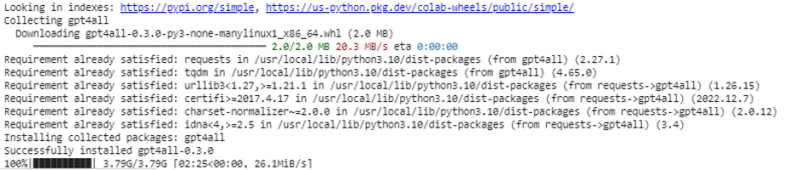

Det hele kræver en online kommando for at installere GPT4All til Python IDE. Derefter kan vi integrere lige så mange AI-modeller som vores applikationer. Kommandoen til at installere denne GPT4All i Python er som vist i følgende:

$ pip installer gpt4all

Eksempel 1:

For at komme i gang med dette eksempel skal vi downloade og installere Python i vores systemer. De anbefalede versioner af Python er 'version 3.7' eller dem, der kom efter denne version. En anden måde at arbejde med Python på for at undgå den lange proces med at installere 'Python-opsætningen' på vores systemer er at bruge 'Google Colab', som er et skybaseret miljø for Python. Vi kan køre dette miljø på enhver webbrowser og kan bygge AI- og maskinlæringsmodellerne. Eksemplerne, som vi vil implementere her, udføres i Google Colab.

Dette eksempel dækker metoden til at installere GPT4All i Python, og hvordan man bruger dens præ-trænede modeller. Vi begynder med først at installere GPT4All. Til det udføres kommandoen, som vi tidligere nævnte. Med udførelsen af kommandoen downloades og installeres GPT4All sammen med dens pakker og rammer.

Nu går vi fremad. Fra GPT4All importerer vi 'GPT4All'. Dette tilføjer alle de fortrænede modeller fra GPT4All til projektet. Nu kan vi bruge enhver enkelt model og få den til at gøre forudsigelserne for vores applikation. Når vi først har importeret GPT4All-pakken, er det nu tid til at kalde denne funktion og bruge GPT4All-modellen, som giver output til 'chat-afslutningen'.

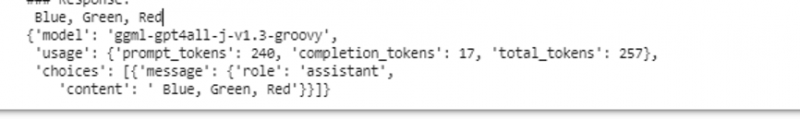

Med andre ord, hvis vi spørger om noget fra den model i inputtet, returnerer den det i outputtet. Den model, vi bruger her, er 'ggml-gpt4all-j-v1.3-groovy'. Disse modeller er allerede gemt i GPT4All-cachen. Vi kan få disse modeller fra dette link ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” til manuel download. Hvis modellen allerede er til stede i GPT4All-cachen, kalder vi blot navnet på modellen og angiver det som inputparametre til funktionen 'GPT4All()'. Hvis vi manuelt downloadede det med succes, sender vi stien til den mappe, hvor modellen er placeret. Da denne model er til meddelelsesfuldførelse, er syntaksen for denne model givet som følger:

$ Chat_completion (beskeder)Meddelelserne er en ordbogsliste, og hver ordbog skal indeholde en 'rolle'-nøgle med en værdi af brugeren, systemet eller assistenten og 'nøgle'-indholdet, som har værdien som strengen. I dette eksempel angiver vi indholdet som 'navn tre farver' og rollenøglen som 'bruger'.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'bruger', 'content': 'Nævn 3 blomster'}]

Efter denne specifikation kalder vi 'chat_completion()'-funktionen med modellen. Koden til dette vises i følgende output:

$ !pip installer gpt4allfra gpt4all import GPT4All

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

beskeder = [{'role': 'bruger', 'content': 'Nævn tre farver'}]

model.chat_completion(beskeder)

Efter udførelsen af dette eksempel returnerer modellen tre farver som svar på input.

Eksempel 2:

Vi dækker et andet eksempel, hvor vi opdager en anden metode til at bruge GPT4All i Python. Dette kan gøres ved at bruge de officielle bindinger til Python, som leveres af 'Nomic', som er et open source AI-fællesskab, og det kører GPT4All. Ved at bruge følgende kommando integrerer vi 'nomic' i vores Python-konsol:

$ pip installer nomicNår dette er installeret, importerer vi GPT4All fra 'nomic.gpt4all'. Efter import af GPT4All initialiserer vi GPT4All med funktionen 'open()'. Derefter kalder vi 'prompt()'-funktionen og sender en prompt til denne funktion. Derefter genereres et promptsvar baseret på den prompt, som vi har givet som input til promptmodellen.

!pip installer nomicfra nomic.gpt4all importerer GPT4All

# Initialiser GPT4All-modellen

initiere = GPT4All()

initiate.open()

# Generering af et svar baseret på prompten

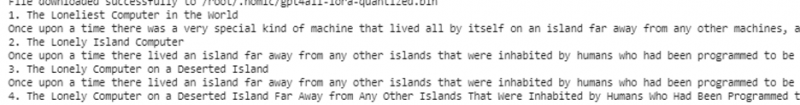

model_response = initiate.prompt('skriv en novelle om en computer)

# viser det genererede svar

print(model_respons)

Outputtet viser det hurtige svar fra modellen, som vi genererede ved hjælp af den præ-trænede GPT4All-model i Python. Hvis vi vil vide mere om modellerne, og hvordan vi kan bruge disse modeller til at generere svarene, eller i enkle ord, hvis vi ønsker at få viden om syntaksen til at generere svarene fra disse modeller, kan vi tage yderligere hjælp fra GPT4All tekniske dokumentationsdetaljer.

Konklusion

GPT4All stræber stadig efter at opnå præstationsnøjagtighed. Den drives af den nomic AI-platform, som har til formål at levere kunstigt intelligente chatbots til sine brugere på forbruger-grade CPU'er, da GPT4All fungerer uden nogen netværksforbindelse og GPU'er. Denne artikel oplyser os til dygtigt at bruge PyGPT4All i et Python-miljø og til at skabe en interaktion mellem vores applikationer og de forudtrænede GPT4All AI-modeller. Vi dækkede to forskellige metoder til, hvordan man installerer GPT4All i Python i denne vejledning.