I denne blog vil fokus være på, hvordan man opnår vægten af et modellag i PyTorch.

Hvad er vægten af et modellag i PyTorch?

“ Vægte ' og ' Fordomme ” er begge væsentlige træk ved de neurale netværksmodeller. Disse er begge parametre, der kan læres, og som løbende opdateres under træningssløjfen med hvert fremadgående pass af modellen. Denne regelmæssige opdatering skyldes en integreret optimizer såsom Adam optimizer. Målet med de neurale netværksmodeller er at lave nøjagtige forudsigelser baseret på inputdata, og vægtene og skævhederne bruges til at justere disse resultater for at minimere tab.

Hvordan opnår man vægten af et modellag i PyTorch?

Det ' vægte ” af et lag gemmes i Python-ordbogen og bruger syntaksen ” state_dict() ”. Ordbogen bruges til at kalde vægtene ved hjælp af nedenstående trin:

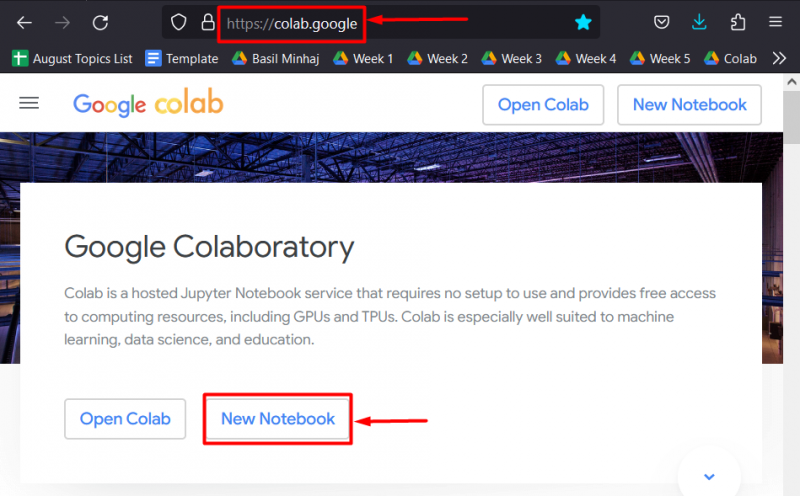

Trin 1: Åbn Colab IDE

Denne vejledning begynder med valget af IDE til projektet. Gå til Kolaboratoriet internet side og start en ' Ny notesbog ” for at begynde at arbejde:

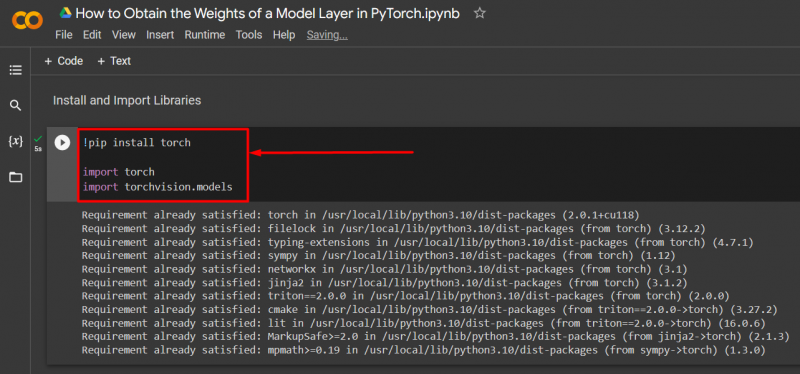

Trin 2: Installer og importer biblioteker

Efter opsætning af Colab-notesbogen, ' installere ' og ' importere ” bibliotekerne, der dækker alle de nødvendige funktionaliteter i projektet:

! pip-installationsbrænderimportere fakkel

importere fakkelsyn. modeller

Ovenstående kode fungerer som følger:

- Det ' pip ”pakkeinstallationsprogram fra python bruges til at installere det væsentlige ” fakkel ” bibliotek.

- Dernæst ' importere kommandoen bruges til at importere den til projektet.

- Til sidst, ' torchvision.modeller ”-pakken importeres også for den ekstra funktionalitet af deep learning-modeller:

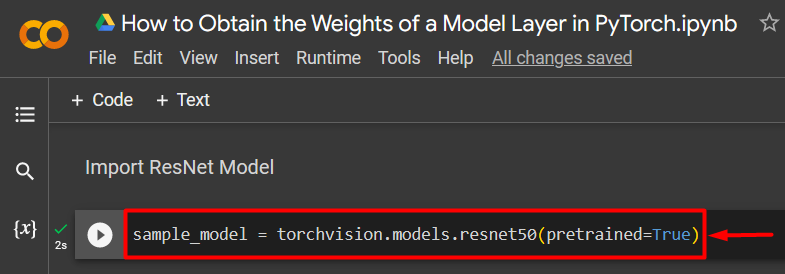

Trin 3: Importer ResNet-model

I denne vejledning er ' ResNet50 ” neural netværksmodel med 50 lag indeholdt i torchvision-biblioteket bruges til demonstration. Importer den fortrænede model som vist:

sample_model = fakkelsyn. modeller . seriøs 50 ( foruddannet = Rigtigt )

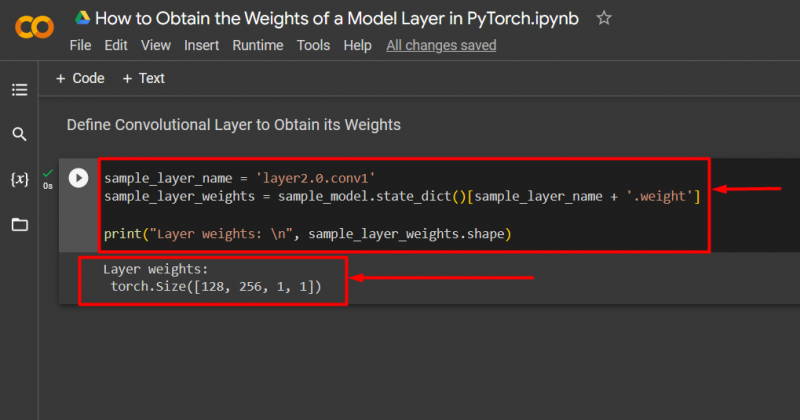

Trin 4: Definer modellaget

Definer modellagets navn og brug ' state_dict() ” metode til at opnå dens vægte som vist:

sample_layer_name = 'layer2.0.conv1'sample_layer_weights = sample_model. state_dict ( ) [ sample_layer_name + '.vægt' ]

Print ( 'Lagvægte: \n ' , sample_layer_weights. form )

Ovenstående kode fungerer som følger:

- Det andet indviklede lag af ResNet50-modellen er tildelt ' sample_layer_name ' variabel.

- Derefter ' state_dict() ”-metoden bruges med ” sample_model variabel, og de tildeles til ' sample_layer_weights ' variabel.

- Det ' sample_layer_name ' og ' .vægt ' tilføjes som argumenter for ' state_dict() ” metode for at opnå vægte.

- Brug endelig ' Print() ” metode til at vise lagvægtene som output:

Nedenstående output viser, at vi har opnået vægten af modellag i Pytorch:

Bemærk : Du kan få adgang til vores Colab Notebook her link .

Pro-Tip

Vægten af et modellag i PyTorch viser træningsløkkens fremskridt. Disse vægte bruges til at fastslå væksten af modellen, da den behandler inputdataene til outputresultaterne og forudsigelserne. At opnå vægten af et lag er vigtigt for at vurdere kvaliteten af resultaterne og for at kontrollere, om der skal foretages forbedringer eller ej.

Succes! Vi har demonstreret, hvordan man opnår vægten af et lag af en PyTorch-model.

Konklusion

Få vægten af et modellag i PyTorch ved hjælp af “state_dict() ”-metode efter import af en model fra torchvision eller brug af en brugerdefineret. Vægten af et modellag er de indlærelige parametre, der konstant opdateres under træning og katalogiserer dets fremskridt. I denne artikel har vi vist, hvordan man importerer ResNet50-modellen fra torchvision og opnår vægten af dets andet indviklede lag.