LangChain er rammen, der indeholder flere afhængigheder og biblioteker, der kan bruges til at bygge store sprogmodeller. Disse modeller kan bruges til at interagere med mennesker, men først skal modellen lære at få/forstå prompten/spørgsmålet stillet af mennesket. Til det skal modellen trænes på promptskabelonerne, og så stiller brugeren spørgsmålet inden for den givne skabelon.

Denne guide vil illustrere processen med at bygge promptskabeloner i LangChain.

Hvordan bygger man promptskabeloner i LangChain?

For at bygge promptskabeloner i LangChain skal du blot gennemgå følgende guide med flere trin:

Trin 1: Installer moduler og opsætningsmiljø

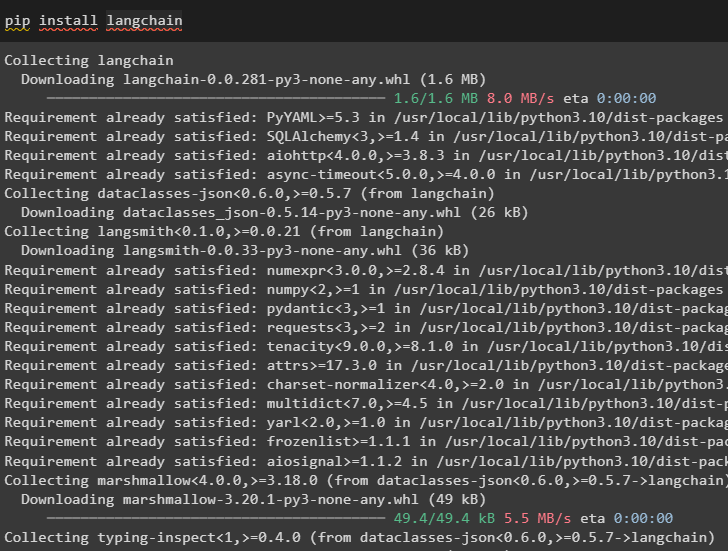

Start processen med at bygge promptskabeloner i LangChain ved at installere LangChain frameworket:

pip installer langkæde

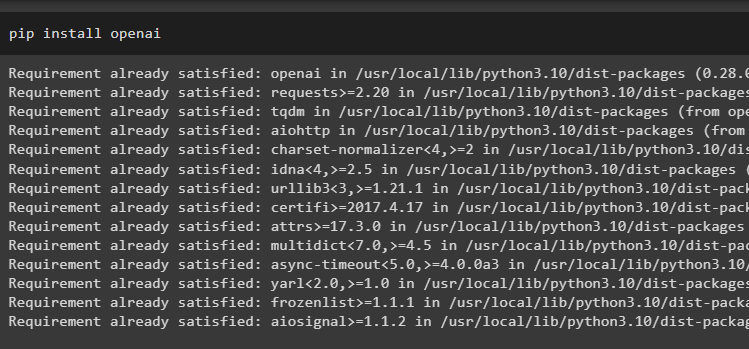

Installer nu OpenAI-moduler for at få adgang til dets biblioteker og indstil et miljø ved hjælp af det:

pip installer openai

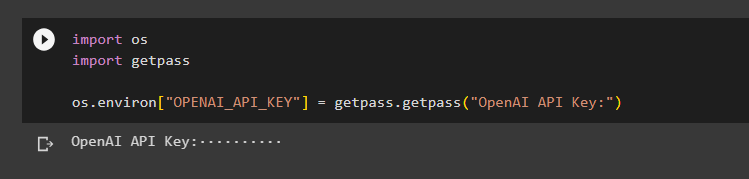

Indstil OpenAI miljø ved at bruge OS-biblioteket til at få adgang til operativsystemet og give OpenAI API-nøglen:

import osimportere getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('OpenAI API-nøgle:')

Trin 2: Brug af promptskabelon

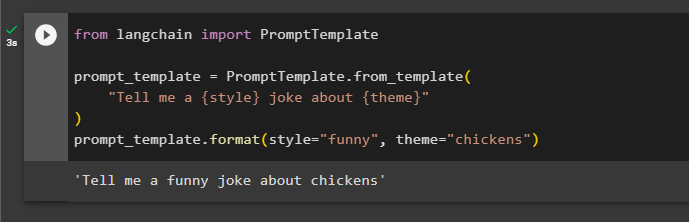

Efter installation af LangChain skal du blot importere PromptTemplate-biblioteket og bygge en skabelon til forespørgslen om en vittighed med nogle ekstra aspekter som variabler som adjektiv, indhold osv.:

fra langchain import PromptTemplateprompt_template = PromptTemplate.from_template(

'Fortæl mig en {stil} joke om {tema}'

)

prompt_template.format(style='sjov', tema='kyllinger')

Prompten er blevet indstillet og givet til modellen med værdierne af variablen indsat i kommandoen:

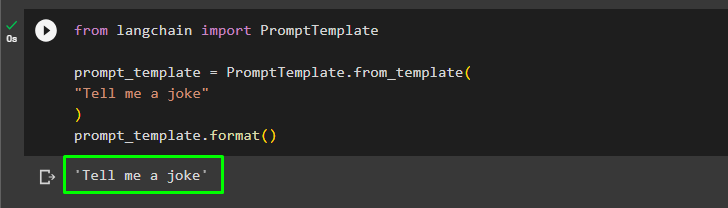

Brugeren kan tilpasse promptskabelonen med en simpel forespørgsel, der beder om en joke:

fra langchain import PromptTemplateprompt_template = PromptTemplate.from_template(

'Fortæl mig en vittighed'

)

prompt_skabelon.format()

Ovenstående metode er til en enkelt forespørgsel og svar, men nogle gange ønsker brugeren at interagere med modellen i form af en chat, og det næste afsnit forklarer dens format.

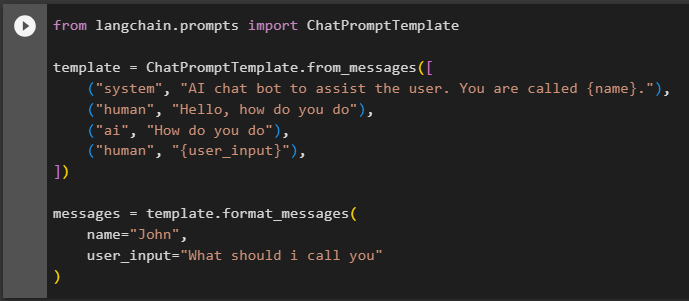

Trin 3: Brug af chatpromptskabelon

Dette afsnit forklarer skabelonen for en chatmodel, som er baseret på et samtalemønster som to mennesker, der interagerer med hinanden:

fra langchain.prompts importerer ChatPromptTemplatetemplate = ChatPromptTemplate.from_messages([

('system', 'AI chat-bot til at hjælpe brugeren. Du kaldes {navn}.')

('menneske', 'Hej, hvordan har du det'),

('ai', 'Hvordan gør du'),

('menneske', '{user_input}'),

])

beskeder = template.format_messages(

,

user_input='Hvad skal jeg kalde dig'

)

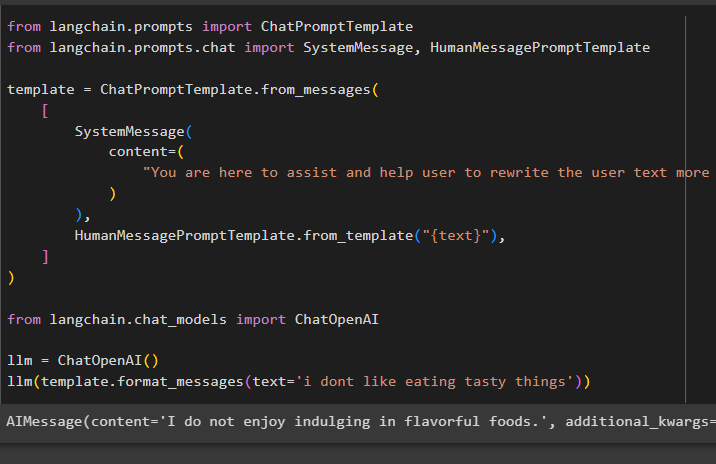

Efter at have indstillet skabelonstrukturen, skal du blot skrive nogle linjer i teksten for at fortælle modellen, hvad der forventes af den, og bruge llm()-funktionen til at give en prompt:

fra langchain.prompts importerer ChatPromptTemplatefra langchain.prompts.chat importer SystemMessage, HumanMessagePromptTemplate

template = ChatPromptTemplate.from_messages(

[

Systemmeddelelse(

indhold=(

'Du er her for at hjælpe og hjælpe brugeren med at omskrive brugerteksten mere effektivt'

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

fra langchain.chat_models importerer ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='jeg kan ikke lide at spise velsmagende ting'))

SystemMessage()-metoden indeholder indholdet af svaret for den forespørgsel, der bruges i LLM:

Det handler om at bygge promptskabeloner i LangChain.

Konklusion

For at bygge en promptskabelon i LangChain skal du blot installere LangChain- og OpenAI-moduler for at opsætte et miljø ved hjælp af OpenAI API-nøglen. Derefter skal du oprette en promptskabelon til en enkelt prompt som at bede om en joke eller et enkelt spørgsmål om hvad som helst. En anden metode er at tilpasse en skabelon til en chatmodel baseret på processen med interaktion mellem to forskellige mennesker. Dette indlæg har illustreret processen med at bygge en promptskabelon i LangChain.